Google’s Bard بر اساس مدل زبان LaMDA است که بر روی مجموعه داده های مبتنی بر محتوای اینترنتی به نام Infiniset آموزش داده شده است.

مقاله تحقیقاتی LaMDA 2022 درصدی از منابع مختلف مورد استفاده برای آموزش LaMDA را فهرست میکند، اما تنها 12.5٪ از مجموعه داده های عمومی از محتوای وب و 12.5٪ دیگر از ویکی پدیا میآید.

مجموعه داده Infiniset Google

Google Bard بر اساس یک مدل زبان به نام LaMDA است که مخفف Language Model for Dialogue Applications است.

LaMDA بر روی مجموعه داده ای به نام Infiniset آموزش داده شد.

Infiniset ترکیبی از محتوای اینترنتی است که عمداً برای افزایش توانایی مدل انتخاب شده است.

مقاله تحقیقاتی LaMDA (PDF) توضیح میدهد که چرا آنها این ترکیب محتوا را انتخاب کردند:

این ترکیب برای دستیابی به عملکرد قوی تر در وظایف محاوره ای انتخاب شد. البته هنوز توانایی خود را برای انجام سایر وظایف مانند تولید کد حفظ میکند.

ما میتوانیم بررسی کنیم که چگونه انتخاب این ترکیب ممکن است بر کیفیت برخی از وظایف NLP انجام شده توسط مدل تأثیر بگذارد.

مقاله پژوهشی به دیالوگ و دیالوگ ها اشاره می کند که املای کلمات استفاده شده در این زمینه در حوزه علوم کامپیوتر است.

در مجموع، LaMDA روی 1.56 تریلیون کلمه “داده های گفتگوی عمومی و متن وب” از قبل آموزش داده شده بود.

مجموعه داده از ترکیب زیر تشکیل شده است:

12.5 درصد داده های مبتنی بر C4

12.5٪ اسناد کد از وبسایت های برنامه نویسی پرسش و پاسخ، آموزش ها و موارد دیگر

6.25٪ اسناد وب غیر انگلیسی

50٪ داده ها را از انجمن های عمومی دریافت میکند

دو بخش اول Infiniset (C4 و Wikipedia) از داده هایی تشکیل شده است که شناخته شده اند.

مجموعه داده C4، که به زودی مورد بررسی قرار خواهد گرفت، یک نسخه فیلتر شده ویژه از مجموعه داده Common Crawl است.

تنها 25 درصد از داده ها از یک منبع نامگذاری شده (مجموعه داده های C4 و ویکی پدیا) به دست آمده است.

بقیه داده هایی که 75 درصد از مجموعه داده های Infiniset را تشکیل میدهند، شامل کلماتی است که از اینترنت حذف شدهاند.

مقاله تحقیقاتی نمیگوید که داده ها چگونه و از چه وبسایت هایی به دست آمده است.

Google فقط از توضیحات کلی مانند “اسناد وب غیر انگلیسی” استفاده میکند.

لغت murky به معنای زمانی است که چیزی توضیح داده نمیشود و بیشتر پنهان است.

Murky بهترین کلمه برای توصیف 75 درصد از داده هایی است که گوگل برای آموزش LaMDA استفاده کرده است.

سرنخ هایی وجود دارد که ممکن است یک ایده کلی از اینکه چه سایت هایی در 75 درصد محتوای وب قرار دارند به دست میدهد، اما ما نمیتوانیم به طور قطع بگوییم.

مجموعه داده C4

C4 مجموعه داده ای است که توسط گوگل در سال 2020 توسعه یافته است. C4 مخفف “Colossal Clean Crawled Corpus” است.

این مجموعه داده بر اساس داده های Common Crawl است که یک مجموعه داده منبع باز است.

درباره Common Crawl

Common Crawl یک سازمان غیرانتفاعی ثبت شده است که به صورت ماهانه در اینترنت میچرخد تا مجموعه داده های رایگان ایجاد کند که هر کسی بتواند از آن استفاده کند.

سازمان Common Crawl در حال حاضر توسط افرادی اداره میشود که برای بنیاد WikiMedia کار کردهاند، Googler های سابق، بنیانگذار Blekko، و افرادی مانند پیتر نورویگ، مدیر تحقیقات گوگل و دنی سالیوان (همچنین از گوگل) به عنوان مشاور به حساب میآیند.

چگونه C4 از Common Crawl توسعه یافته است

داده های خام Common Crawl با حذف مواردی مانند کلمات زشت، lorem ipsum، منوهای ناوبری، کپیبرداری و غیره، مجموعه داده ها را محدود میکند.

هدف از فیلتر کردن داده های غیرضروری حذف ابهامات و حفظ نمونه های انگلیسی طبیعی است.

این همان چیزی است که محققان سازنده C4 نوشتند:

«برای جمعآوری مجموعه دادههای پایه خود، متن استخراجشده وب را از آوریل ۲۰۱۹ دانلود کردیم و فیلتر فوقالذکر را اعمال کردیم.

ما این مجموعه داده را “Colossal Clean Crawled Corpus” (یا به اختصار C4) مینویسیم و آن را به عنوان بخشی از TensorFlow Datasets منتشر میکنیم.

نسخه های فیلتر نشده دیگری از C4 نیز وجود دارد.

مقاله تحقیقاتی که مجموعه داده های C4 را توصیف میکند، با عنوان Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer (PDF) منتشر است.

یک مقاله تحقیقاتی دیگر با نام Documenting Large Webtext Corpora: A Case Study on the Colossal Clean Crawled Corpus – PDF ساختار سایت های موجود در مجموعه داده C4 را بررسی کرد.

جالب اینجاست که دومین مقاله تحقیقاتی ناهنجاری هایی را در مجموعه داده های اصلی C4 کشف کرد که منجر به حذف بعضی صفحات اسپانیایی و آفریقاییتبار شد.

صفحات وب همتراز شده با زبان اسپانیایی توسط فیلتر لیست بلاک (حذف کلمات فحش و غیره) به میزان 32 درصد از صفحات حذف شدند.

صفحات وب تراز شده آفریقایی آمریکایی با میزان 42 درصد حذف شدند.

احتمالاً این مشکلات تاکنون برطرف شده اند.

نکته دیگر این بود که 51.3 درصد از مجموعه داده C4 شامل صفحات وب است که در ایالات متحده میزبانی میشدند.

در نهایت، تجزیه و تحلیل سال 2021 مجموعه داده اصلی C4 تأیید میکند که مجموعه داده تنها کسری از کل اینترنت را نشان میدهد.

در تحلیل آمده است:

«تحلیل ما نشان میدهد که این مجموعه داده بخش قابل توجهی از اینترنت عمومی را نشان میدهد، اما به هیچ وجه نماینده بخش انگلیسی زبان اینترنت نیست.

هنگام ساخت یک مجموعه داده از یک وبسایت، گزارش دامنه هایی که متن از آنها برداشته میشود برای درک مجموعه داده ضروری است. فرآیند جمع آوری داده ها میتواند منجر به توزیع بسیار متفاوت دامنه های اینترنتی با آنچه که انتظار میرود، شود.»

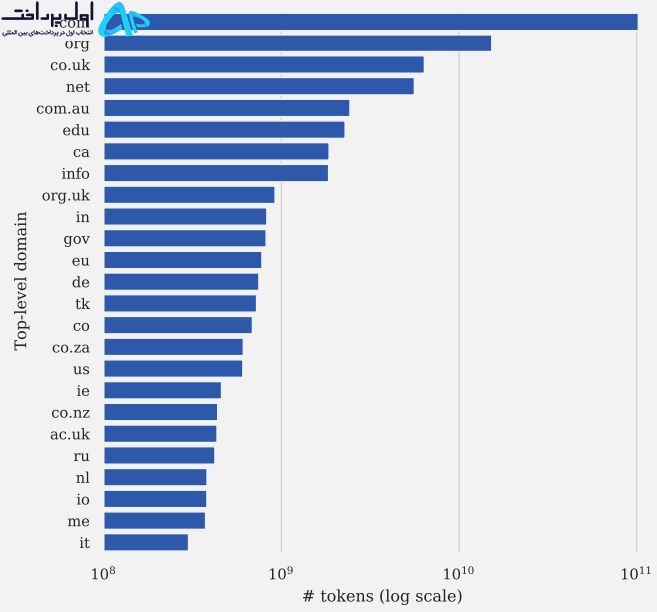

آمار زیر در مورد مجموعه داده C4 از دومین مقاله تحقیقاتی است که در بالا پیوند داده شده است.

25 وبسایت برتر (براساس تعداد توکن ها) در C4 عبارتند از:

1. patents.google.com

2. en.wikipedia.org

3. en.m.wikipedia.org

4. www.nytimes.com

6. www.theguardian.com

8. www.forbes.com

9. www.huffpost.com

10. patents.com

12. www.washingtonpost.com

14. ipfs.io

15. www.frontiersin.org

16. www.businessinsider.com

17. www.chicagotribune.com

18. www.booking.com

19. www.theatlantic.com

20. link.springer.com

22. www.kickstarter.com

23. caselaw.findlaw.com

24. www.ncbi.nlm.nih.gov

25. www.npr.org

اینها 25 دامنه برتر در مجموعه داده C4 هستند:

اگر علاقمند به کسب اطلاعات بیشتر در مورد مجموعه داده C4 هستید، توصیه میکنم که Documenting Large Webtext Corpora: A Case Study on the Colossal Clean Crawled Corpus (PDF) و همچنین مقاله تحقیقاتی اصلی 2020 (PDF) که C4 برای آن ایجاد شده است را مطالعه کنید.

50٪ از داده های آموزشی از ” dialogs data from public forums” میآید.

این تمام چیزی است که مقاله تحقیقاتی LaMDA گوگل در مورد این داده های آموزشی میگوید.

اگر بخواهیم حدس بزنیم، Reddit و دیگر جوامع برتر مانند StackOverflow گزینه های محتملی هستند.

Reddit در بسیاری از مجموعه داده های مهم مانند مجموعه های توسعه یافته توسط OpenAI به نام WebText2 (PDF) و OpenWebText2 استفاده میشود.

گوگل همچنین یک ماه قبل از انتشار مقاله LaMDA جزئیات دیگری از مجموعه داده های سایت های گفتگوی عمومی را منتشر کرد.

این مجموعه داده که حاوی سایت های گفتگوی عمومی است MassiveWeb نامیده می شود.

احتمال میدهیم که مجموعه داده MassiveWeb برای آموزش LaMDA استفاده نشده باشد.

اما این شامل یک مثال خوب از آنچه گوگل برای مدل زبان دیگری که بر دیالوگ متمرکز بود، انتخاب کرد.

MassiveWeb توسط DeepMind که متعلق به گوگل است ایجاد شده است.

برای استفاده توسط یک مدل زبان بزرگ به نام Gopher طراحی شده است.

MassiveWeb از منابع وب محاوره ای که فراتر از Reddit هستند استفاده میکند تا از تاثیر گرفتن از مطالب زشت Reddit جلوگیری کند.

البته هنوز از Reddit استفاده میکند. همچنین حاوی داده هایی است که از بسیاری از سایت های دیگر برداشته شده اند.

سایت های گفتگوی عمومی موجود در MassiveWeb عبارتند از:

- Quora

- YouTube

- Medium

- StackOverflow

باز هم، این نشان نمیدهد که LaMDA با سایت های فوق آموزش دیده است.

منظور این است که نشان دهد گوگل چه چیزی را میتواند استفاده کند.

37.5٪ باقی مانده

آخرین گروه از منابع داده عبارتند از:

12.5٪ اسناد کد از سایت های مرتبط با برنامه نویسی مانند سایت های پرسش و پاسخ، آموزش و غیره.

6.25٪ اسناد وب انگلیسی

6.25٪ اسناد وب غیر انگلیسی.

گوگل مشخص نمیکند که چه سایت هایی در دسته سایت های پرسش و پاسخ برنامه نویسی قرار دارند که 12.5٪ از مجموعه داده ای آموزشی LaMDA را تشکیل میدهد.

بنابراین ما فقط میتوانیم حدس بزنیم.

Stack Overflow و Reddit گزینه های واضحی به نظر میرسند، به خصوص که در مجموعه داده MassiveWeb گنجانده شدهاند.

چه سایت های “آموزشی” استفاده شدند؟ ما فقط میتوانیم حدس بزنیم که آن سایت های “آموزش” ممکن است چه باشند.

ویکی پدیای انگلیسی نیازی به توضیح ندارد، همه ما ویکی پدیا را میشناسیم.

اما دو مورد زیر واضح نیستند:

صفحات وب انگلیسی و غیر انگلیسی.

این تمام اطلاعاتی است که گوگل در مورد این بخش از داده های آموزشی ارائه میدهد.

آیا گوگل باید در مورد مجموعه داده های استفاده شده برای Bard شفاف باشد؟

برخی از ناشران از اینکه سایت هایشان برای آموزش سیستم های هوش مصنوعی استفاده شود احساس ناراحتی میکنند زیرا به نظر آنها این سیستم ها در آینده میتوانند وبسایت هایشان را منسوخ و بیفایده کنند.

اینکه آیا این درست است یا نه، باید دید، اما این یک نگرانی واقعی است که توسط ناشران و اعضای جامعه بازاریابی داده بیان شده است.

گوگل در مورد وبسایت هایی که برای آموزش LaMDA استفاده میشوند و همچنین فناوری هایی که برای کاوش در وبسایت ها استفاده شده، به طور عجیبی پاسخ های ناواضح میدهد.

همانطور که در تجزیه و تحلیل مجموعه داده های C4 مشاهده شد، روش انتخاب محتوای وبسایت برای آموزش مدل های زبان بزرگ میتواند کیفیت مدل زبان را با حذف جمعیت های خاص تحت تاثیر قرار دهد.

آیا گوگل باید در مورد اینکه چه سایت هایی برای آموزش هوش مصنوعی خود استفاده می شود شفاف تر باشد یا حداقل یک گزارش شفاف سازی آسان در مورد داده های استفاده شده منتشر کند؟

نظرات کاربران