با این 14 نکته مفید گرد آوری شده در این مقاله می توانید بیاموزید که چگونه با موفقیت بهبود Crawling گوگل را برای سایت خود داشته باشید.

پیمایش سایت های سازمانی دارای تمام پیچیدگی های هر پیمایش معمولی به علاوه چندین عامل اضافی نیز است که باید قبل از شروع پیمایش در نظر گرفته شوند.

رویکرد های زیر نشان می دهد که چگونه می توان یک پیمایش در مقیاس بزرگ را انجام داد و به اهداف داده شده دست یافت، چه بخشی از یک بررسی مداوم باشد یا یک ممیزی در سایت، تفاوتی وجود ندارد.

1.بهبود Crawling گوگل: سایت را برای پیمایش آماده کنید

نکته مهمی که قبل از پیمایش باید در نظر گرفت خود وب سایت است.

رفع مشکلاتی که ممکن است قبل از شروع پیمایش باعث کاهش سرعت پیمایش شود، مفید است.

ممکن است رفع مشکل قبل از رفع آن غیر منطقی به نظر برسد، اما وقتی صحبت از سایت های واقعا بزرگ می شود، یک مشکل کوچک ضربدر پنج میلیون به یک مشکل مهم تبدیل می شود.

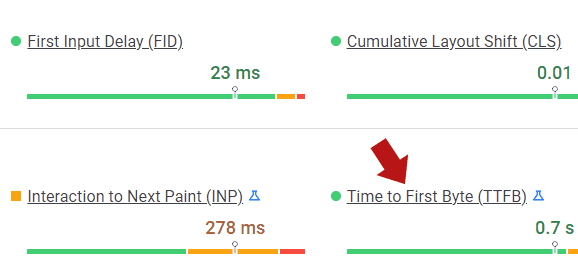

آدام هامفریس، بنیانگذار آژانس بازاریابی دیجیتال Making 8 Inc.، راه حل هوشمندانه ای را به اشتراک گذاشت که از آن برای شناسایی عواملی که باعث کندی TTFB (زمان تا اولین بایت) می شود استفاده می کند، معیاری که میزان پاسخگویی یک وب سرور را اندازه می گیرد.

بایت یک واحد داده است. بنابراین TTFB اندازه گیری مدت زمانی است که طول می کشد تا یک بایت داده به مرورگر تحویل داده شود.

TTFB مدت زمان بین دریافت درخواست یک فایل توسط سرور تا زمانی که اولین بایت به مرورگر تحویل داده می شود را اندازه گیری می کند، بنابراین اندازه گیری سرعت سرور را ارائه می دهد.

یک راه برای اندازه گیری TTFB این است که یک URL را در ابزار PageSpeed Insights Google وارد کنید، که توسط فناوری اندازه گیری Lighthouse Google طراحی شده است.

بهبود Crawling گوگل

آدام این متن را به اشتراک گذاشته است که: «بنابراین بسیاری از اوقات، Core Web Vitals یک TTFB کند را برای صفحاتی که در حال ممیزی هستند علامت گذاری می کند. برای به دست آوردن یک خواندن TTFB واقعاً دقیق، می توان فایل متنی خام را مقایسه کرد، فقط یک فایل متنی ساده بدون HTML، که روی سرور به وبسایت واقعی بارگذاری می شود.

مقداری Lorem ipsum یا چیزی را روی یک فایل متنی بریزید و آن را آپلود کنید سپس TTFB را اندازه بگیرید. ایده این است که زمان پاسخ سرور را در TTFB ببینید و سپس جداسازی کنید که چه منابعی در سایت باعث تاخیر می شوند.

بیشتر اوقات این افزونه های بیش از حدی است که مردم دوست دارند. من هر دو Lighthouse را در حالت ناشناس و web.dev/measure را به روزرسانی می کنم تا میانگین اندازه گیری ها را انجام دهم. وقتی من 30 تا 50 افزونه یا تن جاوا اسکریپت را در کد منبع می بینم، قبل از شروع هر پیمایش تقریباً یک مشکل فوری است.

وقتی آدام میگوید در حال تازهسازی امتیازات Lighthouse است، منظورش این است که چندین بار URL را آزمایش می کند، زیرا هر آزمایش یک امتیاز کمی متفاوت به شما می دهد (که به دلیل این واقعیت است که سرعت مسیریابی داده ها از طریق اینترنت دائماً در حال تغییر است. درست مثل اینکه سرعت ترافیک دائما در حال تغییر است).

بنابراین کاری که آدام انجام می دهد این است که چندین امتیاز TTFB را جمع آوری می کند و آنها را میانگین می دهد تا به یک نمره نهایی برسد که سپس به او می گوید که یک وب سرور چقدر پاسخگو است.

اگر سرور پاسخگو نیست، ابزار PageSpeed Insights می تواند ایده ای درباره اینکه چرا سرور پاسخگو نیست و چه چیزی باید اصلاح شود را به شما ارائه دهد.

2. اطمینان از دسترسی کامل به سرور: IP پیمایش کننده ی لیست سفید

فایروال ها و CDN ها (شبکه های تحویل محتوا) می توانند یک IP را از پیمایش یک وب سایت مسدود یا کند کنند.

بنابراین مهم است که همه افزونه های امنیتی، نرم افزارهای پیشگیری از نفوذ در سطح سرور و CDN هایی را که ممکن است مانع پیمایش سایت شوند، شناسایی کنید.

پلاگین های معمولی وردپرس برای افزودن IP به لیست سفید عبارتند از Sucuri Web Application Firewall (WAF) و Wordfence.

3. در ساعات کم پیک پیمایش کنید

پیمایش یک سایت در حالت ایده آل باید بدون مزاحمت باشد.

در بهترین سناریو، سرور باید بتواند با پیمایش تهاجمی مقابله کند و در عین حال صفحات وب را به بازدید کنندگان واقعی سایت نیز ارائه دهد.

اما از سوی دیگر، آزمایش میزان پاسخگویی سرور تحت بارگذاری می تواند مفید نیز باشد.

اینجاست که تجزیه و تحلیل بلادرنگ یا دسترسی به گزارش سرور مفید خواهد بود زیرا بلافاصله می توانید ببینید که چگونه پیمایش سرور ممکن است بر بازدید کنندگان سایت تأثیر بگذارد، اگرچه سرعت پیمایش و پاسخهای 503 سرور نیز سرنخی از تحت فشار بودن سرور شما است.

اگر واقعاً اینطور است که سرور تلاش می کند تا به آن ادامه دهد، آن پاسخ را یادداشت کنید و سایت را در ساعات غیر اوج مصرف نیز بررسی کنید.

البته ین مورد شایان ذکر است که یک CDN در هر صورت باید اثرات یک پیمایش تهاجمی را کاهش دهد.

4. آیا خطاهای سرور وجود دارد؟

اگر سرور در ارائه صفحات به Googlebot با مشکل مواجه است، گزارش آمار پیمایش کنسول جستجوی Google باید اولین مکان برای تحقیق باشد.

هر مشکلی در گزارش آمار پیمایش باید قبل از پیمایش یک وب سایت در سطح سازمانی، علت شناسایی و رفع شود.

گزارش های خطای سرور یک معدن طلا از داده ها هستند که می توانند طیف وسیعی از خطا ها را به شما نشان دهند که ممکن است بر میزان خوبی پیمایش یک سایت تأثیر بگذارد. از اهمیت ویژه ای برخوردار است که بتوان خطا های PHP غیرقابل مشاهده را نیز اشکال زدایی کرد.

5.بهبود Crawling گوگل: حافظه سرور

شاید چیزی که به طور معمول برای سئو در نظر گرفته نمی شود، مقدار RAM (حافظه دسترسی تصادفی) است که یک سرور دارد.

RAM مانند حافظه کوتاه مدت است، جایی که سرور اطلاعاتی را که برای ارائه صفحات وب به بازدیدکنندگان سایت استفاده می کند، ذخیره می کند.

پس این مورد را بایستی در نظر داشت که سرور با RAM ناکافی طبیعتا کند می شود.

بنابراین اگر یک سرور در حین پیمایش کند می شود یا به نظر نمی رسد که بتواند با پیمایش کنار بیاید، این می تواند یک مشکل سئو باشد که بر میزان توانایی گوگل در پیمایش و فهرست بندی صفحات وب تأثیر می گذارد.

حتما در این مواقع نگاهی به مقدار رم سرور بیندازید.

یک VPS (سرور خصوصی مجازی) ممکن است به حداقل 1 گیگابایت RAM نیاز داشته باشد.

با این حال، اگر وب سایت یک فروشگاه آنلاین با ترافیک بالا باشد، ممکن است 2 تا 4 گیگابایت RAM برای استفاده به شما توصیه شود.

البته که RAM بیشتر به طور کلی بهتر است.

اگر سرور مقدار RAM کافی داشته باشد اما سرعت سرور کند شود، ممکن است مشکل چیز دیگری باشد، مانند نرم افزار (یا یک افزونه) که ناکارآمد است و باعث نیاز به حافظه بیش از حد می شود.

6. به طور دوره ای داده های Crawl را تأیید کنید

هنگام پیمایش وب سایت، مراقب نا هنجاری های پیمایش باشید.

گاهی اوقات پیمایش کننده ممکن است گزارش دهد که سرور قادر به پاسخگویی به درخواست یک صفحه وب نیست و چیزی شبیه پیام پاسخ سرور 503 سرویس ناموجه است.

بنابراین برای شما مفید است که پیمایش را متوقف کنید و ببینید چه اتفاقی در حال وقوع است که ممکن است نیاز به تعمیر داشته باشد تا به پیمایشی که اطلاعات مفید تری ارائه می دهد ادامه دهید.

گاهی اوقات نرسیدن به پایان پیمایش این هدف است.

پیمایش به خودی خود یک نقطه داده مهم است، بنابراین احساس نا امیدی نکنید که پیمایش برای رفع مشکل باید متوقف شود زیرا کشف چیز خوبی برای شما است.

7. پیمایش کننده ی خود را برای مقیاس پیکربندی کنید

خارج از نقاط حاشیه ای، پیمایش کننده ای مانند Screaming Frog ممکن است برای سرعت تنظیم شود که احتمالا برای اکثر کاربران عالی است. اما برای اینکه بتواند در یک وب سایت بزرگ با میلیون ها صفحه پیمایش کند باید تنظیم شود.

Screaming Frog از RAM برای پیمایش خود استفاده می کند که برای یک سایت معمولی عالی است اما برای یک وب سایت با اندازه سازمانی کمتر عالی می شود.

غلبه بر این نقص با بررسی تنظیمات ذخیره سازی در Screaming Frog آسان است.

این مسیر منو برای بررسی تنظیمات ذخیره سازی در این پیمایش کننده است:

Configuration > System > Storage > Database Storage

در صورت امکان، استفاده از هارد دیسک داخلی SSD (درایو حالت اصلی) به شدت توصیه می شود (اما کاملاً ضروری نیست).

اکثر کامپیوتر ها از یک هارد دیسک استاندارد با قطعات متحرک داخل آن استفاده می کنند.

SSD پیشرفته ترین شکل هارد دیسک است که می تواند اطلاعات را با سرعتی بین 10 تا 100 برابر سریعتر از هارد دیسک معمولی انتقال دهد.

استفاده از رایانه ای با نتایج SSD به دستیابی به پیمایش سریع شگفت انگیزی کمک می کند که برای دانلود مؤثر میلیون ها صفحه وب ضروری است.

برای اطمینان از پیمایش بهینه، باید 4 گیگابایت رم و حداکثر 4 گیگابایت برای پیمایش تا 2 میلیون URL اختصاص دهید.

برای پیمایش تا 5 میلیون URL، توصیه می شود که 8 گیگابایت رم اختصاص داده شود.

آدام هامفریس این متن را به اشتراک گذاشته است که: «پیمایش سایت ها به طور باورنکردنی نیازمند منابع است و به حافظه زیادی نیاز دارد. دسکتاپ اختصاصی یا اجاره سرور روشی بسیار سریعتر از لپ تاپ است.من یک بار تقریباً دو هفته را در انتظار تکمیل پیمایش گذراندم. من از آن یاد گرفتم و شرکای برای ساختن نرمافزار از راه دور گرفتم تا بتوانم ممیزی را در هر مکانی در هر زمان انجام دهم.

8.بهبود Crawling گوگل: اتصال به اینترنت سریع

اگر در حال پیمایش از دفتر خود هستید، استفاده از سریعترین اتصال اینترنتی ممکن بسیار مهم است.

استفاده از سریع ترین اینترنت موجود می تواند به معنای تفاوت بین پیمایش که ساعت ها طول می کشد تا پیمایش چند روز به طول بیانجامد.

به طور کلی، این مورد را در نظر بگیرید که سریع ترین اینترنت موجود از طریق اتصال اترنت است و نه از طریق اتصال Wi-Fi.

اگر دسترسی به اینترنت شما از طریق Wi-Fi است، هنوز هم می توانید با نزدیک تر کردن لپ تاپ یا دسک تاپ به روتر Wi-Fi، که دارای اتصالات اترنت در پشت است، اتصال اترنت برای سیستم خود برقرار کنید.

به نظر می رسد این یکی از آن توصیه های «ناگفته» است، اما نادیده گرفتن آن آسان است، زیرا اکثر مردم به طور پیشفرض از Wi-Fi استفاده می کنند، بدون اینکه واقعاً به این فکر کنند که چقدر سریع تر میتوان از طریق سیم اترنت کامپیوتر را مستقیماً به روتر وصل کرد.

9.بهبود Crawling گوگل: Cloud Crawling

گزینه دیگر برای شما، به ویژه برای پیمایش سایت فوق العاده بزرگ و پیچیده با بیش از 5 میلیون صفحه وب، پیمایش از سرور می تواند بهترین گزینه باشد.

هنگام استفاده از سرور ابری، تمام محدودیت های عادی از پیمایش دسک تاپ غیرفعال هستند.

Ash Nallawalla، متخصص سئوی سازمانی و نویسنده در این زمینه، بیش از 20 سال تجربه کار با برخی از بزرگترین شرکت های فناوری سازمانی جهان را دارد.

بنابراین از او درباره نحوه ی پیمایش میلیون ها صفحه پرسیدیم.

او پاسخ داد که پیمایش از فضای ابری را برای سایت هایی با بیش از 5 میلیون URL توصیه می کند.

Ash این متن را به اشتراک گذاشت که: «پیمایش در وب سایت های بزرگ بهتر است در فضای ابری انجام شود. من تا 5 میلیون URI را با Screaming Frog روی لپ تاپم در حالت ذخیره سازی پایگاه داده انجام می دهم، اما سایت های ما صفحات بسیار بیشتری دارند، بنابراین ماشین های مجازی را در فضای ابری اجرا می کنیم تا آنها را پیمایش کنند.

محتوای ما بیشتر از کپی کردن مقالات برای محتوای متنی آن ها، به دلایل رقابتی هوش داده، در بین اسکراپر ها محبوب است.

ما از فناوری فایروال برای جلوگیری از جمع آوری صفحات زیاد با سرعت بالا استفاده می کنیم. تشخیص خراش هایی که به اصطلاح در حالت شبیه سازی انسانی عمل می کنند به اندازه کافی خوب است. بنابراین، ما فقط می توانیم از آدرس های IP در لیست سفید و لایه ای دیگر از احراز هویت پیمایش کنیم.»

آدام هامفریس نیز با ارائه ی توصیه ای پیمایش از ابر موافقت کرد.

او گفت: «پیمایش سایت ها بهطور باور نکردنی نیازمند منابع است و به حافظه زیادی نیاز دارد. دسکتاپ اختصاصی یا اجاره سرور روشی بسیار سریعتر از لپ تاپ است. من یک بار تقریباً دو هفته را در انتظار تکمیل پیمایش گذراندم.

من از آن تجربه درس گرفتم و شرکای خود را برای ساختن نرم افزار از راه دور گرفتم تا بتوانم ممیزی را در هر مکانی در هر زمان از ابر انجام دهم.

10.بهبود Crawling گوگل: Crawl های جزئی

یک تکنیک برای پیمایش وب سایت های بزرگ این است که سایت را به قسمت هایی تقسیم کرده و هر قسمت را بر اساس ترتیب پیمایش انجام دهید تا نتیجه یک نمای مقطعی از وب سایت باشد.

روش دیگر برای انجام پیمایش جزئی این است که سایت را به قطعات تقسیم کنید و به طور مداوم پیمایش کنید تا عکس فوری هر بخش نه تنها به روز نگه داشته شود بلکه هر تغییری که در سایت ایجاد شده است می تواند فوراً توسط شما مشاهده شود.

بنابراین به جای انجام یک پیمایش به روز رسانی چرخشی در کل سایت، یک پیمایش جزئی کل سایت را بر اساس زمان انجام دهید.

این رویکردی است که Ash قویاً آن را به افراد توصیه می کند.

Ash در این زمینه توضیح داده است که: “من همیشه یک پیمایش دارم. من در حال حاضر یکی را روی یک برند محصول اجرا می کنم. این پیکربندی به گونه ای تنظیم شده است که پیمایش در حد پیش فرض 5 میلیون URL متوقف شود.

وقتی دلیل پیمایش مداوم را از او پرسیدیم، گفت که این به دلیل مسائلی است که خارج از کنترل او است که ممکن است با کسب و کارهایی با این اندازه که بسیاری از سهامداران درگیر هستند اتفاق بیفتد.

Ash گفت: “برای موقعیتم، من یک پیمایش مداوم برای رسیدگی به مسائل شناخته شده در یک منطقه خاص دارم.”

11. عکس فوری کلی: پیمایش محدود

یک راه برای دریافت نمای سطح بالا از ظاهر یک وب سایت این است که پیمایش را فقط به نمونه ای از سایت محدود کنید.

این مورد برای پیمایش هوش رقابتی نیز مفید است.

به عنوان مثال، در پروژه ای که من روی آن کار می کردم، حدود 50000 صفحه را از وب سایت یک رقیب جستجو کردم تا ببینم آنها به چه نوع سایت هایی لینک می دهند.

من از آن داده ها استفاده کردم تا مشتری را متقاعد کنم که الگو های پیوند خروجی آنها ضعیف است و به آنها سایت های باکیفیت را نشان دادم که رقبای رتبه اول آنها به آنها پیوند می دادند.

بنابراین گاهی اوقات، یک پیمایش محدود می تواند به اندازه کافی نوع خاصی از داده ها را به دست آورد تا شما یک ایده کلی از سلامت کلی سایت بدست آورید.

12. Crawl For Site Structure Overview

گاهی اوقات افراد تنها نیاز به درک ساختار سایت دارند.

برای انجام سریع تر این کار، می توان پیمایش کننده را طوری تنظیم کرد که پیوند های خارجی و تصاویر داخلی را پیمایش نکند.

تنظیمات پیمایش کننده ی دیگری نیز وجود دارد که می توان آن ها را حذف کرد تا پیمایش سریع تر نیز ایجاد شود، به طوری که تنها چیزی که پیمایش کننده روی آن تمرکز می کند دانلود URL و ساختار پیوند است.

13. نحوه مدیریت صفحات تکراری و Canonical

مگر اینکه دلیلی برای نمایه سازی صفحات تکراری وجود داشته باشد، تنظیم پیمایش کننده برای نادیده گرفتن پارامتر های URL و سایر URL هایی که تکراری از یک URL متعارف هستند می تواند برای شما مفید باشد.

این امکان وجود دارد که یک پیمایش کننده را فقط برای پیمایش صفحات متعارف تنظیم کنید. اما اگر شخصی صفحات صفحه بندی شده را طوری تنظیم کند که به صفحه اول متوالی تبدیل شوند، هرگز شما این خطا را کشف نخواهید کرد.

البته ممکن است شما به یک دلیل مشابه، حداقل در پیمایش اولیه، ممکن است بخواهید از برچسب های noindex برای شناسایی نمونه هایی از دستورالعمل noindex در صفحاتی که باید ایندکس شوند، اطاعت نکنید.

14. هرآنچه گوگل می بیند را شما هم ببینید

همانطور که بدون شک متوجه شده اید، راه های مختلفی برای پیمایش یک وب سایت متشکل از میلیون ها صفحه وب وجود دارد.

بودجه پیمایش به میزان منابعی است که گوگل برای پیمایش یک وب سایت برای ایندکس کردن اختصاص می دهد.

هرچه صفحات وب بیشتری با موفقیت ایندکس شوند، صفحات بیشتری فرصت رتبه بندی دارند.

با این اوصاف سایت های کوچک واقعاً نباید نگران بودجه پیمایش گوگل باشند.

اما به حداکثر رساندن بودجه پیمایش گوگل یک اولویت برای وب سایت های سازمانی است.

در سناریوی قبلی که در بالا نشان داده شد، توصیه کردیم به برچسب های noindex توجهی نکنید.

برای این نوع پیمایش شما در واقع می خواهید از دستورالعمل های noindex پیروی کنید زیرا هدف برای این نوع پیمایش گرفتن عکس فوری از وب سایت است که به شما می گوید Google چگونه کل وب سایت را می بیند.

کنسول جستجوی Google اطلاعات زیادی را ارائه می کند، اما پیمایش خود در یک وب سایت با یک عامل کاربری که بهعنوان Google پنهان شده است، ممکن است اطلاعات مفیدی به دست آورد که می تواند به بهبود فهرست بندی بیشتر صفحات مناسب کمک کند و در عین حال متوجه شوید که گوگل ممکن است بودجه پیمایش را در کدام صفحات هدر دهد.

برای این نوع پیمایش، مهم است که عامل کاربر پیمایش کننده را روی Googlebot تنظیم کنید، پیمایش کننده را روی robots.txt تنظیم کنید، و آن را برای اطاعت از دستورالعمل noindex تنظیم کنید.

به این ترتیب، اگر سایت طوری تنظیم شده باشد که عناصر صفحه خاصی را به Googlebot نشان ندهد، شما نیز می توانید نقشه سایت را همانطور که گوگل می بیند ببینید.

این یک راه عالی برای تشخیص مشکلات احتمالی مانند کشف صفحاتی است که باید پیمایش شوند اما در حال از دست دادن هستند.

برای سایت های دیگر، گوگل ممکن است راه خود را به صفحاتی بیابد که برای کاربران مفید هستند، اما ممکن است از نظر گوگل کیفیت پایینی داشته باشند، مانند صفحاتی که فرم های ثبت نام دارند.

پیمایش با عامل کاربر گوگل برای درک اینکه گوگل چگونه سایت را می بیند و به حداکثر رساندن بودجه پیمایش کمک می کند و برایتان بسیار مفید است.

شکست دادن سختی یادگیری

می توان وب سایت های سازمانی را جستجو کرد و نحوه پیمایش به روش دشوار را در آنها را یاد گرفت. امیدواریم این چهارده نکته از سختی یادگیری کم کند و شما را برای پذیرش مشتریان در سطح سازمانی با وب سایت های غول پیکر آماده تر کند.

امیدواریم این مقاله اطلاعات مورد نیاز شما در زمینه ی پیمایش صفحات وب را در اختیارتان قرار داده باشد.

همچنین شما می توانید جهت تکمیل اطلاعات خود در این زمینه دیگر مقالات ما را مطالعه بفرمایید.

نظرات کاربران